Comment libérer le potentiel de votre entreprise grâce au Small Data ?

Introduction

C’est quoi le small Data ?

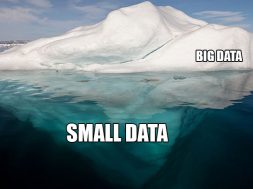

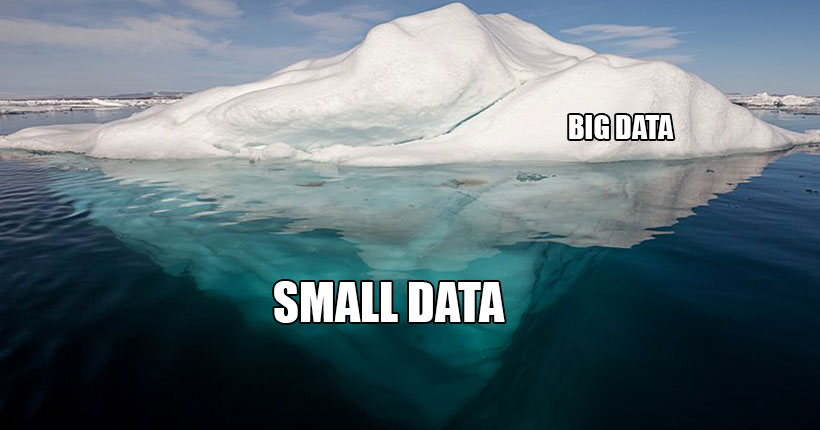

A l’inverse du Big Data, “Le small data est la quantité de données que vous pouvez aisément stocker et utiliser sur une seule machine. Cela peut être votre ordinateur portable ou un serveur de haute qualité”.

Selon Wikipedia: “Les petites données sont des données suffisamment «petites» pour la compréhension humaine. Ce sont des données dans un volume et un format qui les rendent accessibles, informatives et exploitables. Le terme «big data» concerne les machines et les «petites données» concernent les personnes”1.

Pourquoi parler du Small Data à l’ère du Big Data

C’est quoi le Big Data ?

Le terme big data fait référence aux données ayant une forte volumétrie, une grande variété et qui évoluent rapidement. D’ailleurs, l’une des principales caractéristiques du Big Data est le coût généralement trop élevé de stockage, de gestion et d’analyse des données dans des systèmes de base de données traditionnels.

Pourquoi le small data ?

Le Small data, moins connu que le Big Data représente pourtant 85% des données collectées par les entreprises.

De toute évidence, toutes les entreprises, ne possèdent pas forcément des pétaoctets de données. Je pense plus particulièrement à nos PME, nos TPE et nos Agriculteurs.

Les personnes et les organisations qui s’intéressent à l’analyse et la compréhension de leurs données, ne commencent jamais par des pétaoctets de données. De même, les data engineer, passent plus de 70% de leur temps de travail dans la collecte, la transformation et le “nettoyage” des données pour les rendre exploitables par les autres métiers (Data analystes, Data scientists, etc). En règle générale, Ils réalisent ce travail sur un petit ensemble de données.

Cependant, il est possible que vos données possèdent déjà l’une des deux autres caractéristiques essentielles du big data. Et si vous pouvez être sûr d’une chose, c’est que vos données vont croître avec le temps, probablement de manière exponentielle. À cet égard, le point de départ du « big data » est un « petit » volume de données.

“le battage médiatique autour du big data est déplacé – les petites données liées sont là où réside la vraie valeur”.

– Rufus Pollock, entrepreneur social et directeur de l’Open Knowledge Foundation.

L’impact du small data sur la croissance des entreprises

Small vs Big Data: le nouvel Or noir pour les entreprises?

Selon le rapport 2020 du Capgemini Research Institute, les entreprises qui maîtrisent l’utilisation de leurs données ont des performances financières largement supérieures aux autres, réalisant plus de 70% de gain de revenus par salarié et 22% en termes de rentabilité.

Encore faut-il pouvoir recueillir et analyser correctement ces jeux de données. Les modèles prédictives prennent alors tout leur sens. Les entreprises qui investissent sur ce domaine gagnent en temps et en efficacité.

Les grandes entreprises n’ont plus le monopole des données:

Pour rendre l’analyse des données accessible au plus grand nombre, la technologie joue un rôle essentiel dans ce processus. En 2020, selon une étude d’IBM, deux-tiers des entreprises françaises annonçaient utiliser ou déployer de l’intelligence artificielle. Dans ce contexte, la démocratisation du cloud computing (tels que Google Cloud, Amazon Redshift, Microsoft Azure, etc), a baissée fortement les coûts de stockage, de traitement et d’exploitation des données. De ce fait, les grandes entreprises n’ont plus le monopole des usages technologiques.

L’impact du small data sur l’avenir de l’IA

Small Data et le Besoin d’IA en données ?

L’IA (Intelligence Artificielle) est un ensemble de technologies qui imite l’intelligence humaine. L’apprentissage automatique est l’une des technologies phares de l’IA. Elle permet aux ordinateurs d’apprendre sans avoir été programmés explicitement pour cela.

Les algorithmes dits « supervisés », représentent actuellement la majorité des programmes d’apprentissage automatique. C’est à dire qu’ils ont besoins de données annotés en entrée, pour alimenter les modèles d’analyse prédictifs. De même, il faudrait collecter massivement les données, les traiter et les annoter pour nourrir ces programmes d’apprentissage automatique. Un domaine dans lequel les géants du numérique excellent, comme Facebook, Amazon, Google, Microsoft, etc.

D’ailleurs, plusieurs scandales ont éclatés récemment au niveau mondial à cause de cette collecte massive des données, où la vie privée et parfois bafouée. Des applications comme Siri et Alexia, se basent sur des enregistrements réels (par exemple, lorsque vous passer commande à votre moteurs de recherche par la voix, ou lorsque vous parler à Siri pour trouver une information). “Le système de reconnaissance vocale BAIDU utilise un ensemble énorme de données (données collectées mais aussi synthétisées) pour apprendre la robustesse au bruit et la variation de voix entre les locuteurs »2

Rendre l’IA moins gourmande en Big Data ?

Un rapport du Gartner prédit que d’ici 2025, 70% des entreprises passeront de grandes à petites et larges données (donc de Big à small data), offrant ainsi plus de contextes pour l’analyse et rendant l’intelligence artificielle (IA) moins gourmande en données.

Actuellement, les trois technologies d’apprentissage automatique sont: Apprentissage supervisé, non supervisé et par renforcement. “L’apprentissage non supervisé est un problème d’apprentissage automatique où le logiciel doit trouver des structures sous-jacentes dans les données non annotées. L’apprentissage par renforcement marche grâce à des mesures de récompense par essai-erreur”3.

Afin d’éviter de collecter et d’annoter une grande quantité de données, il faudrait se tourner vers l’apprentissage automatique en ligne, sur des données réelles. L’idée consiste à modifier les algorithmes actuels ou les combiner pour qu’ils utilisent peu de données, capturées en permanence à partir du monde réel. La santé, les transports, l’environnement et la défense sont les 4 axes qualifiés de prioritaires en France/Europe, et sur lesquels nous devons exceller grâce à l’intelligence artificielle.

Conclusion

Pour conclure, nous pouvons dire avec certitude que la prochaine décennie appartient aux modèles distribués non centralisés, à la collaboration et non au contrôle, et aux petites données « Small Data » et non au big data. De même, l’apprentissage automatique en ligne et sur un petit ensemble de données, dans le respect de la vie privée des individus, nous fera entrer dans une nouvelle ère technologique grâce à l’intelligence artificielle.